「負の二項分布」という名前から二項分布の一般化のように思えてしまいそうですが,実は負の二項分布は幾何分布の一般化になっています.

例えば「表が一定の確率で出るコインを繰り返し投げて,初めて表が出るまでの裏の回数」は幾何分布に従うのでした.

この幾何分布を一般化した確率分布が負の二項分布で,「コインを繰り返し投げて決めた回数表が出るまでの裏の回数」が従う確率分布を負の二項分布と言います.

二項分布と負の二項分布は別物です.「負の二項分布」の名前の由来はこの記事の最後で解説しています.

この記事では

- 負の二項分布の定義・基本性質

- 負の二項分布の具体例

- 期待値・分散・確率母関数の幾何分布を用いた導出

- 期待値・分散・確率母関数の定義からの導出

- 補足(なぜ「負の二項分布」という名前なのか?)

を順に説明します.

「重要な確率分布」の一連の記事

- 離散型確率分布の定義と期待値・分散・母関数

- 連続型確率分布の定義と期待値・分散・母関数

- 連続型一様分布(準備中)

- 正規分布(準備中)

- カイ二乗分布(準備中)

- t分布(準備中)

- F分布(準備中)

- ガンマ分布(準備中)

- ベータ分布(準備中)

負の二項分布の定義・基本性質

まずは負の二項分布の定義を説明し,そのあと負の二項分布に従う確率変数の具体例を紹介します.

定義($X\sim\mrm{NB}(r,p)$)

そもそも離散型確率変数$X$の確率関数$p_X$は

\begin{align*}p_X(k)=P(X=k)\end{align*}

と定義されるのでした.つまり,$X=k$となる確率を$p_X(k)$と表すことを思い出しておきましょう.

$r$を正の整数,$p$は$0<p<1$を満たす実数とする.離散型確率変数$X$がパラメータ$r$, $p$の負の二項分布(negative binomial distribution)に従うとは,$X$の確率関数$p_X$が

\begin{align*}p_X(k)=\binom{r+k-1}{k}p^{r}(1-p)^{k}\quad(k=0,1,2,3,\dots)\end{align*}

を満たすことをいう.また,このとき$X\sim\mrm{NB}(r,p)$などと表す.

$\binom{n}{m}$は二項係数で,高校数学で学ぶ組み合わせの場合の数${}_{n}\!\operatorname{C}_{m}$と同じです:$\binom{n}{m}=\frac{n!}{m!(n-m)!}$.

確率関数$p_X(k)$を

\begin{align*}p_X(k)=\binom{r+k-1}{k}p^{r-1}(1-p)^{k}\times p\quad(k=0,1,2,3,\dots)\end{align*}

とみると意味が分かります.

反復試行の確率より$\binom{r+k-1}{k}p^{r-1}(1-p)^{k}$は「成功確率$p$のベルヌーイ試行を$(r+k-1)$回繰り返す中で$(r-1)$回成功する($k$回失敗する)確率」ですから,$p_X(k)$は「成功確率$p$のベルヌーイ試行を繰り返して$r$回成功するまでに$k$回失敗する確率」です.

よって,負の二項分布$\mrm{NB}(r,p)$に従う確率変数$X$とは,成功確率$p$のベルヌーイ試行を繰り返し,$r$回成功するまでの失敗の回数をとる確率変数のことをいうわけですね.

期待値$E[X]$・分散$V[X]$・確率母関数$G_X(s)$

のちに導出するように,負の二項分布の期待値・分散・確率母関数は次のようになります.

$X\sim\mrm{NB}(p)$の期待値$E[X]$,分散$V[X]$,確率母関数$G_X(s)$は

\begin{align*}E[X]=\frac{(1-p)r}{p},\quad

V[X]=\frac{(1-p)r}{p^2},\quad

G_X(s)=\bra{\frac{p}{1-s+sp}}^{r}\end{align*}

である.ただし,確率母関数の定義域は$|s|<\frac{1}{1-p}$である.

確率母関数は$G_X(s)=E[s^X]$と定義されるので,$s=e^{t}$と置き換えれば積率母関数

\begin{align*}M_X(t)=E[e^{tX}]=\bra{\frac{p}{1-e^t+e^tp}}^r\end{align*}

が得られ,$s=e^{it}$と置き換えれば特性関数

\begin{align*}\phi_X(t)=E[e^{itX}]=\bra{\frac{p}{1-e^{it}+e^{it}p}}^r\end{align*}

が得られますね.

負の二項分布の具体例

負の二項分布に従う確率変数として,コイン,サイコロを具体的に考えます.

具体例1(コイン):$\mrm{NB}(2,\frac{1}{3})$

冒頭で紹介したように,歪んだコインを表が2回出るまで投げ続けたときの「裏が出る回数」は負の二項分布に従います.

投げると表が確率$\dfrac{1}{3}$で出る歪んだコインを投げ続け,表が2回出るまでの裏の回数を確率変数$X$とすると,$X$はどのような負の二項分布に従うか?

$X$は0以上の整数のいずれかの値をとる.正の整数$k$に対して,$X=k$ということは

- $(k+1)$回目までに表が1回出る(確率$\binom{k+1}{k}(1-\frac{1}{3})^{k}\frac{1}{3}$)

- $(k+2)$回目で表が出る(確率$\frac{1}{3}$)

ということなので,

\begin{align*}p_X(k)&=P(X=k)=\binom{k+1}{k}\bra{1-\frac{1}{3}}^{k}\frac{1}{3}\times\frac{1}{3}

\\&=\binom{2+k-1}{k}\bra{\frac{1}{3}}^{2}\bra{1-\frac{1}{3}}^{k}\end{align*}

である.よって,$X$はパラメータ2, $\frac{1}{3}$の負の二項分布に従う($X\sim\mrm{NB}(2,\frac{1}{3})$).

運によってはすぐに表が2回出ることもあれば,いつまで経っても裏が出続けることもあります.確率は非常に低いですが,100回裏が出続ける確率は0ではありません.

そのため,$X$は全ての正の整数の値をとり得ることに注意してください.

具体例2(サイコロ):$\mrm{NB}(3,\frac{5}{6})$

各目が均等に出る6面サイコロを振り続け,1〜5の目が3回出るまでの6の目が出た回数を確率変数$X$とすると,$X$はどのような負の二項分布に従うか?

$X$は0以上の整数のいずれかの値をとる.正の整数$k$に対して,$X=k$ということは

- $(k+2)$回目の間で1〜5の目が2回出る(確率$\binom{k+2}{k}(1-\frac{5}{6})^{k}(\frac{5}{6})^2$)

- $(k+1)$回目で表が出る(確率$\frac{5}{6}$)

ということなので,

\begin{align*}p_X(k)&=P(X=k)=\binom{k+2}{k}\bra{1-\frac{5}{6}}^{k}\bra{\frac{5}{6}}^2\times\frac{5}{6}

\\&=\binom{k+2}{k}\bra{\frac{5}{6}}^3\bra{1-\frac{5}{6}}^{k}\end{align*}

である.よって,$X$はパラメータ3, $\frac{5}{6}$の負の二項分布に従う($X\sim\mrm{NB}(3,\frac{5}{6})$).

具体例1のコインと同様に,運によってはすぐに1〜5の目が出ることもあれば,いつまで経っても6が出続けることもあります.

そのため,$X$は全ての正の整数の値をとり得ることに注意してください.

期待値・分散・確率母関数の幾何分布を用いた導出

負の二項分布$\mrm{NB}(r,p)$の期待値・分散・母関数を,幾何分布$\mrm{Geo}(p)$の期待値・分散・母関数と比較すると

- 期待値と分散は$n$倍

- 母関数は$n$乗

になっています.これは偶然ではなく,次の事実に基づいて証明することができます.

負の二項分布と幾何分布の関係

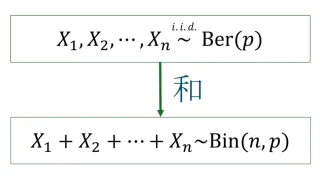

ベルヌーイ分布と二項分布の関係として「互いに独立な$X_1,X_2,\dots,X_n\sim \mrm{Ber}(p)$に対して,$X_1+X_2+\dots+X_n\sim\mrm{Bin}(n,p)$が成り立つ」というものがあります.

実は,幾何分布と負の二項分布にも同様の関係が成り立ちます.

独立な$X_1,X_2,\dots,X_r\sim \mrm{Geo}(p)$に対して,

\begin{align*}X_1+X_2+\dots+X_r\sim\mrm{NB}(r,p)\end{align*}

が成り立つ.

幾何分布は初めて成功するまでの失敗の回数が従う確率分布なのでした.

一方,負の二項分布の「$r$回成功する」を,「初めて成功するまでを$r$回繰り返す」と思えば,この定理は直観的に理解できますね.

期待値$E[X]$の導出

$X\sim\mrm{NB}(r,p)$の期待値は$E[X]=\dfrac{(1-p)r}{p}$である.

独立な$X_1,X_2,\dots,X_r\sim \mrm{Geo}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_r\end{align*}

と表せる.幾何分布$\mrm{Geo}(p)$に従う確率変数の期待値は$\frac{1-p}{p}$だったから,期待値$E$の線形性を併せて

\begin{align*}E[X]=E[X_1]+E[X_2]+\dots+E[X_r]=\frac{(1-p)r}{p}\end{align*}

を得る.

分散$V[X]$の導出

$X\sim\mrm{NB}(r,p)$の分散は$V[X]=\dfrac{(1-p)r}{p^2}$である.

独立な$X_1,X_2,\dots,X_r\sim \mrm{Geo}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_r\end{align*}

と表せる.幾何分布$\mrm{Geo}(p)$に従う確率変数の分散は$\frac{1-p}{p^2}$だったから,分散$V$の展開公式より

\begin{align*}V[X]=V[X_1]+V[X_2]+\dots+V[X_r]=\frac{(1-p)r}{p^2}\end{align*}

を得る.ただし,1つ目の等号では,独立な確率変数$X$, $Y$に対して一般に

\begin{align*}V[X+Y]=V[X]+V[Y]+\operatorname{Cov}[X,Y]=V[X]+V[Y]\end{align*}

が成り立つことを用いた.

確率母関数$G_X(s)$の導出

$X\sim\mrm{NB}(r,p)$の確率母関数$G_X(s)$は

\begin{align*}G_X(s)=\bra{\frac{p}{1-s+sp}}^r\quad\bra{|s|<\frac{1}{1-p}}\end{align*}

である.

独立な$X_1,X_2,\dots,X_r\sim \mrm{Geo}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_r\end{align*}

と表せる.幾何分布$\mrm{Geo}(p)$に従う確率変数の確率母関数は

\begin{align*}\frac{p}{1-s+sp}\quad\bra{|s|<\frac{1}{1-p}}\end{align*}

だったから,$|s|<\frac{1}{1-p}$で

\begin{align*}G_{X}(s)&=E[s^{X}]=E[s^{X_1+X_2+\dots+X_r}]

\\&=E[s^{X_1}s^{X_2}\dots s^{X_r}]

\\&=E[s^{X_1}]E[s^{X_2}]\dots E[s^{X_r}]

\\&=\bra{\frac{p}{1-s+sp}}^r\end{align*}

を得る.ただし,最後から2つ目の等号では,独立な確率変数$X$, $Y$に対して一般に$E[XY]=E[X]E[Y]$が成り立つことを用いた.

期待値・分散・確率母関数の定義からの導出

幾何分布との関係を使わなくても,確率母関数をマクローリン展開を用いて導出することもでき,確率母関数の導関数を用いて期待値・分散も求められます.

確率母関数$G_X(s)$の導出

$X\sim\mrm{NB}(r,p)$の確率母関数$G_X(s)$は

\begin{align*}G_X(s)=\bra{\frac{p}{1-s+sp}}^r\quad\bra{|s|<\frac{1}{1-p}}\end{align*}

である.

確率母関数$G_X(s)$の定義より

\begin{align*}G_X(s)&=E[s^X]=\sum_{k=0}^{\infty}s^k\cdot p_X(k)

\\&=\sum_{k=0}^{\infty}s^k\cdot\binom{r+k-1}{k}p^{r}(1-p)^{k}

\\&=p^{r}\sum_{k=0}^{\infty}\binom{r+k-1}{k}(s-sp)^{k}\end{align*}

である.以下,

\begin{align*}(1-(s-sp))^{-r}=\sum_{k=0}^{\infty}\binom{r+k-1}{k}(s-sp)^{k}\end{align*}

が成り立つことを示す.

$(1-x)^{-r}$のマクローリン展開

$f(x):=(1-x)^{-r}$とおき,$f(x)$のマクローリン展開を考える.$f$の$k$階導関数は

\begin{align*}\frac{d^kf}{dx^k}(x)

&=(-r)(-r-1)\dots(-r-k+1)(-1)^{k}\cdot(1-x)^{-r-k}

\\&=r(r+1)\dots(r+k-1)(1-x)^{-r-k}

\\&=k!\cdot\frac{r(r+1)\dots(r+k-1)}{k!}(1-x)^{-r-k}

\\&=k!\binom{r+k-1}{k}(1-x)^{-r-k}\end{align*}

なので,$x=0$での$k$階微分係数は

\begin{align*}\frac{d^kf}{dx^k}(0)&=k!\binom{r+k-1}{k}(1-0)^{-r-k}

\\&=k!\binom{r+k-1}{k}\end{align*}

である($k=0,1,2,\dots$).よって,$f(x)$のマクローリン展開は

\begin{align*}f(x)&=\sum_{k=0}^{\infty}f^{(k)}(0)x^k

\\&=\sum_{k=0}^{\infty}\binom{r+k-1}{k}x^k\quad\dots(*)\end{align*}

となる.$x=s-sp$を代入して

\begin{align*}f(s-sp)=\sum_{k=0}^{\infty}\binom{r+k-1}{k}(s-sp)^{k}\end{align*}

なので,

\begin{align*}G_X(s)=p^{r}(1-(s-sp))^{-r}=\bra{\frac{p}{1-s+sp}}^r\end{align*}

を得る.

収束半径と定義域

マクローリン展開$(*)$の収束半径は

\begin{align*}&\left.\binom{r+k-1}{k}\middle/\binom{r+(k+1)-1}{k+1}\right.

\\&=\frac{(r+k-1)(r+k-2)\dots(r+1)r/k!}{(r+k)(r+k-2)\dots(r+1)r/(k+1)!}

\\&=\frac{k+1}{r+k}\xrightarrow[]{k\to\infty}1\end{align*}

より,1であることが分かる.

よって,$f(x)$のマクローリン展開$(*)$は$|x|<1$で定義されるから,$f(s-sp)$

\begin{align*}|s-sp|<1\iff |s|<\frac{1}{1-p}\end{align*}

で定義される.よって,確率母関数$G_X(s)$は$|s|<\frac{1}{1-p}$で定義される.

平均$E[X]$の導出

$X\sim\mrm{NB}(r,p)$の期待値は$E[X]=\dfrac{(1-p)r}{p}$である.

$0<p<1$より$|1|<\frac{1}{1-p}$なので,$s<\frac{1}{1-p}$は$s=1$を含む.よって,確率母関数

\begin{align*}G_X(s)=\bra{\frac{p}{1-s+sp}}^r\quad\bra{|s|<\frac{1}{1-p}}\end{align*}

は$s=1$で定義されている.

一般に$G’_X(1)=E[X]$であり,$G_X(s)$の$s=1$での微分係数は

\begin{align*}G’_X(s)&=\left.\frac{d}{ds}(p^r(1-s+sp)^{-r})\right|_{s=1}

\\&=\left.p^r(-1+p)(-r)(1-s+sp)^{-r-1}\right|_{s=1}

\\&=\left.\frac{p^r(1-p)r}{(1-s+sp)^{r+1}}\right|_{s=1}=\frac{p^r(1-p)r}{p^{r+1}}=\frac{(1-p)r}{p}\end{align*}

なので,$E[X]=\frac{(1-p)r}{p}$を得る.

分散$V[X]$の導出

$X\sim\mrm{NB}(r,p)$の分散は$V[X]=\dfrac{(1-p)r}{p^2}$である.

$X$の分散は

\begin{align*}V[X]&=E[X^2]-E[X]^2

\\&=E[X(X-1)]+E[X]-E[X]^2\end{align*}

で求まる.$E[X]=\frac{(1-p)r}{p}$は上で求めたから,あとは$E[X(X-1)]$を求めればよい.

$E[X]=\frac{(1-p)r}{p}$の証明で説明したように,確率母関数$G_X(s)$は$s=1$で定義されている.

一般に$G^{\prime\prime}_X(1)=E[X(X-1)]$であり,$G_X(s)$の$s=1$での2階微分係数は

\begin{align*}G’_X(s)&=\left.\frac{d}{ds}(p^r(1-p)r(1-s+sp)^{-r-1})\right|_{s=1}

\\&=\left.p^r(1-p)r(-1+p)(-r-1)(1-s+sp)^{-r-2}\right|_{s=1}

\\&=\left.p^r(1-p)^2r(r+1)(1-s+sp)^{-r-2}\right|_{s=1}

\\&=\frac{p^r(1-p)^2r(r+1)}{p^{r+2}}=\frac{(1-p)^2r(r+1)}{p^2}\end{align*}

なので,$E[X(X-1)]=\frac{(1-p)^2r(r+1)}{p^2}$を得る.以上より,

\begin{align*}V[X]&=\frac{(1-p)^2r(r+1)}{p^2}+\frac{(1-p)r}{p}-\bra{\frac{(1-p)r}{p}}^2

\\&=\frac{(1-p)^2r(r+1)+p(1-p)r-(1-p)^2r^2}{p^2}

\\&=\frac{\{(1-p)+p\}(1-p)r}{p^2}=\frac{(1-p)r}{p^2}\end{align*}

を得る.

補足(なぜ「負の二項分布」という名前なのか?)

最後に「負の二項分布」という名前の由来を解説します.

負の二項分布の確率関数の変形

負の二項分布に従う確率変数$X\sim\mrm{NB}(r,p)$の確率関数は

\begin{align*}p_X(k)&=\binom{r+k-1}{k}p^{r}(1-p)^{k}

\\&=\frac{(r+k-1)(r+k-2)\dots(r+1)r}{k!}p^{r}(1-p)^{k}

\\&=\frac{(-r)(-r-1)\dots(-r-k+2)(-r-k+1)}{k!}p^{r}(p-1)^{k}

\\&=\binom{-r}{k}p^{r}(p-1)^{k}\end{align*}

と変形できます.最後から2つ目の等号では,分子は$k$個の因数からなるので,$k$個の$p-1$を−1倍して辻褄を合わせました.

$\binom{x}{k}=\frac{x(x-1)\dots(x-k+2)(x-k+1)}{k!}$は正の整数$x$に対してだけではなく,任意の実数$x$に対しても同様に定義されます.この$\binom{x}{k}$は一般化された二項係数と言います.

二項分布の確率関数との比較

通常の二項分布は次のように定義されるのでした.

$p$を$0<p<1$を満たす実数とし,$n$を正の整数とする.離散型確率変数$X$がパラメータ$n$, $p$の二項分布(binomial distribution)に従うとは,$X$の確率関数$p_X$が

\begin{align*}p_X(k)=\binom{n}{k}p^{k}(1-p)^{n-k}\end{align*}

を満たすことをいう.また,このとき$X\sim\mrm{Bin}(n,p)$などと表す.

上の負の二項分布と,この定義の二項分布の確率密度関数で$-r$と$n$が対応していることが見て取れます.

二項分布の$n$はベルヌーイ試行の回数でしたから,負の二項分布で$n$に対応する「負の」整数$-r$に注目して「負の二項分布」というわけですね.

参考文献

以下は参考文献です.

現代数理統計学の基礎

[久保川達也 著/共立出版]

現代の統計学は社会学・心理学・機械学習など様々な分野に応用されている極めて実学的な分野です.

本書は本格的な統計学の基礎から,近年広く応用されている統計手法を学ぶことができるテキストで,

- 第1部:統計的推測を行う上で必要な確率・確率分布の基本的な事項

- 第2部:確率分布に関する推測方法

- 第3部:発展的な内容

の3部構成になっています(本書「はしがき」より).

著者が大学3,4年生に向けて行った講義に基づいて書かれており,全体的に簡潔に説明されているのが特徴です.

また,章末問題も豊富にあり,統計検定の準1級・1級の対策としても利用できます(たとえば,統計検定1級の「数理統計」は本書の第5章までをしっかり学べば十分対応できます).

さらに,著者による章末問題の略解がウェブにアップロードされているのも独学者にはありがたい点です.

コメント