一定の確率で表が出るコインを投げ,1回ごとに

- 表が出たとき1点

- 裏が出たとき0点

とするとき,投げたときの合計点数は0点,1点,2点,3点のいずれかになりますね.

この合計点数は「$n$回コインを投げたときの表の回数」と言っても同じですね.

このコイン投げの点数のように,値0か値1を定める試行を$n$回行ったときの合計の値($0,1,2,\dots,n$)が従う確率分布を二項分布といいます.

この記事では

- 反復試行の確率の具体例と確率の公式

- 二項分布の定義・基本性質

- 二項分布の具体例

- 平均・分散・確率母関数の導出(ベルヌーイ分布を用いる方法)

- 平均・分散・確率母関数の導出(定義から直接求める方法)

を順に説明します.

「重要な確率分布」の一連の記事

- 離散型確率分布の定義と期待値・分散・母関数

- 連続型確率分布の定義と期待値・分散・母関数

- 連続型一様分布(準備中)

- 正規分布(準備中)

- カイ二乗分布(準備中)

- t分布(準備中)

- F分布(準備中)

- ガンマ分布(準備中)

- ベータ分布(準備中)

反復試行の具体例と確率の公式

二項分布を理解するためには,まずは反復試行の確率を理解する必要があります.

具体例(コインの表が出る確率)

この記事の冒頭のコインについて,次の問題を解きましょう.

投げると表が確率$\dfrac{1}{3}$で出る歪んだコインを投げ,表が出たとき1点,裏が出たとき0点とする.コインを3回投げたとき,合計点数が2点となる確率を求めよ.

コインを3回投げて合計得点が2点となるパターンは,コインの裏表が

- 表表裏(確率$\frac{1}{3}\cdot\frac{1}{3}\cdot\frac{2}{3}=\frac{2}{27}$)

- 表裏表(確率$\frac{1}{3}\cdot\frac{2}{3}\cdot\frac{1}{3}=\frac{2}{27}$)

- 裏表表(確率$\frac{2}{3}\cdot\frac{1}{3}\cdot\frac{1}{3}=\frac{2}{27}$)

となる場合のいずれかであり,これらは互いに排反なので,これらの確率を合算して

\begin{align*}\frac{2}{27}+\frac{2}{27}+\frac{2}{27}=\frac{8}{27}\end{align*}

が求める確率である.

この問題のように,同じ試行を繰り返し行うことを反復試行といいます.

反復試行の確率の公式

いまの問題を一般化して次の定理が成り立ちます(証明もいまの解答と本質的に同様).

成功確率が$p$の試行を$n$回繰り返す.このとき,$n$回中$k$回成功する確率は

\begin{align*}\binom{n}{k}p^{k}(1-p)^{n-k}\end{align*}

である.

$\binom{n}{m}$は二項係数で,高校数学で学ぶ組み合わせの場合の数${}_{n}\!\operatorname{C}_{m}$と同じです:$\binom{n}{m}=\frac{n!}{m!(n-m)!}$.

$n$回中$k$回成功するパターンは,1回目〜$n$回目のうちから$k$回成功する回を選ぶ場合の数に等しいから$\binom{n}{k}$である.

また,いずれのパターンも$k$回成功し,($n-k$)回失敗しているから,それぞれのパターンも起こる確率は等しく

\begin{align*}p^{k}(1-p)^{n-k}\end{align*}

である.いずれのパターンも互いに排反なので,これらの確率を合算して

\begin{align*}\binom{n}{k}p^{k}(1-p)^{n-k}\end{align*}

$n$回中$k$回成功する確率である.

上の問題では$n=3$, $k=2$だったので,パターンは

\begin{align*}\binom{n}{k}=\binom{3}{2}=\frac{3!}{2!(3-2)!}=3\end{align*}

通りあったわけですね.

二項分布の定義・基本性質

まずは二項分布の定義を説明し,そのあと二項分布に従う確率変数の具体例を紹介します.

定義($X\sim\mrm{Bin}(n,p)$)

そもそも離散型確率変数$X$の確率関数$p_X$は

\begin{align*}p_X(k)=P(X=k)\end{align*}

と定義されるのでした.つまり,$X=k$となる確率を$p_X(k)$と表すことを思い出しておきましょう.

$p$を$0<p<1$を満たす実数とし,$n$を正の整数とする.離散型確率変数$X$がパラメータ$n$, $p$の二項分布(binomial distribution)に従うとは,$X$の確率関数$p_X$が

\begin{align*}p_X(k)=\binom{n}{k}p^{k}(1-p)^{n-k}\end{align*}

を満たすことをいう.また,このとき$X\sim\mrm{Bin}(n,p)$などと表す.

反復試行の確率より,二項分布に従う確率変数は成功確率$p$のベルヌーイ試行を$n$回繰り返したときの,成功回数を返す確率変数ということができますね.

よって,$n=1$のときはベルヌーイ分布と全く同じ確率分布になりますね:$\mrm{Ber}(p)=\mrm{Bin}(1,p)$

期待値$E[X]$・分散$V[X]$・確率母関数$G_X(s)$

のちに導出するように,二項分布の期待値・分散・確率母関数は次のようになります.

$X\sim\mrm{Bin}(n,p)$の期待値$E[X]$,分散$V[X]$,確率母関数$G_X(s)$は

\begin{align*}&E[X]=np,\quad

V[X]=np(1-p),\quad

G_X(s)=(sp+1-p)^n\end{align*}

である.

確率母関数は$G_X(s)=E[s^X]$と定義されるので,$s=e^{t}$と置き換えれば積率母関数

\begin{align*}M_X(t)=E[e^{tX}]=(e^{t}p+1-p)^n\end{align*}

が得られ,$s=e^{it}$と置き換えれば特性関数

\begin{align*}\phi_X(t)=E[e^{itX}]=(e^{it}p+1-p)^n\end{align*}

が得られますね.

二項分布の具体例

二項分布に従う確率変数として,コイン,サイコロを具体的に考えます.

具体例1(コイン):$\mrm{Bin}(3,\frac{1}{3})$

投げると表が確率$\dfrac{1}{3}$で出る歪んだコインを投げ,表が出たとき1点,裏が出たとき0点とする.コインを3回投げたときの点数を確率変数$X$とすると,$X$はどのような二項分布に従うか?

$X$は0,1,2,3のいずれかの値をとる.$X=0$となる(全て裏の)確率は

\begin{align*}p_X(0)=P(X=0)=P(\text{0回表})=\binom{3}{0}\bra{\frac{1}{3}}^0\bra{1-\frac{1}{3}}^3\end{align*}

であり,同様に,$X=1,2,3$となる(表が1,2,3回出る)確率は

\begin{align*}&p_X(1)=P(X=1)=P(\text{1回表})=\binom{3}{1}\bra{\frac{1}{3}}^1\bra{1-\frac{1}{3}}^2,

\\&p_X(2)=P(X=2)=P(\text{2回表})=\binom{3}{2}\bra{\frac{1}{3}}^2\bra{1-\frac{1}{3}}^1,

\\&p_X(3)=P(X=3)=P(\text{3回表})=\binom{3}{3}\bra{\frac{1}{3}}^3\bra{1-\frac{1}{3}}^0\end{align*}

である.よって,$X$はパラメータ3, $\frac{1}{3}$の二項分布に従う($X\sim\mrm{Bin}(3,\frac{1}{3})$).

冒頭ではコインの表を1点・裏を0点としたときの合計点数を考えましたが,これはコインの表を成功・裏を失敗と考えたときの成功の回数と同じですね.

具体例2(サイコロ):$\mrm{Bin}(4,\frac{5}{6})$

各目が均等に出る6面サイコロを1回振り,

- 1,2,3,4,5の目が出たとき1点

- 6の目が出たとき0点

とする.サイコロを4回振るとき,合計点数を確率変数$X$とすると,$X$はどのような二項分布に従うか?

この問題の1〜5の目が出たときに成功(値1).6の目が出たときに失敗(値0)と考えるわけですね.

1〜6の出目自体は$X$ではないことに注意してください.$X$はあくまで点数なので$X=0,1,2,3$です.

$X$は0,1,2,3,4のいずれかの値をとる.$X=0$となる(1〜5の目が0回出る)確率は

\begin{align*}p_X(0)=P(X=0)=P(\text{1〜5の出目が0回})=\binom{4}{0}\bra{\frac{5}{6}}^0\bra{1-\frac{5}{6}}^4\end{align*}

となる.同様に$X=0$となる(6の目が出る)確率は

\begin{align*}&p_X(1)=P(X=1)=P(\text{1〜5の出目が1回})=\binom{4}{1}\bra{\frac{5}{6}}^1\bra{1-\frac{5}{6}}^3,

\\&p_X(2)=P(X=2)=P(\text{1〜5の出目が2回})=\binom{4}{2}\bra{\frac{5}{6}}^2\bra{1-\frac{5}{6}}^2,

\\&p_X(3)=P(X=3)=P(\text{1〜5の出目が3回})=\binom{4}{3}\bra{\frac{5}{6}}^3\bra{1-\frac{5}{6}}^1,

\\&p_X(4)=P(X=4)=P(\text{1〜5の出目が4回})=\binom{4}{4}\bra{\frac{5}{6}}^4\bra{1-\frac{5}{6}}^0\end{align*}

だから,$X$はパラメータ4, $\frac{5}{6}$の二項分布に従う($X\sim\mrm{Bin}(4,\frac{5}{6})$).

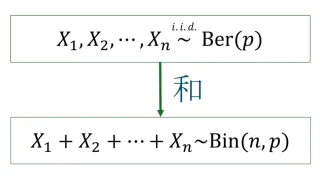

平均・分散・確率母関数の導出(ベルヌーイ分布を用いる方法)

二項分布$\mrm{Bin}(n,p)$の期待値・分散・母関数を,ベルヌーイ分布$\mrm{Ber}(p)$の期待値・分散・母関数と比較すると

- 期待値と分散は$n$倍

- 母関数は$n$乗

になっています.これは偶然ではなく,次の事実に基づいて証明することができます.

独立な$X_1,X_2,\dots,X_n\sim \mrm{Ber}(p)$に対して,

\begin{align*}X_1+X_2+\dots+X_n\sim\mrm{Bin}(n,p)\end{align*}

が成り立つ.

各$X_i$は1回のベルヌーイ試行で成功すれば値1,失敗すれば値0をとるので,$X_1+X_2+\dots+X_n$は$n$回中の成功回数に等しいですから,$X_1+X_2+\dots+X_n$が二項分布に従うことも直観的に分かりますね.

期待値$E[X]$の導出

$X\sim\mrm{Bin}(n,p)$の期待値は$E[X]=np$である.

独立な$X_1,X_2,\dots,X_n\sim \mrm{Ber}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_n\end{align*}

と表せる.ベルヌーイ分布$\mrm{Ber}(p)$に従う確率変数の期待値は$p$だったから,期待値$E$の線形性を併せて

\begin{align*}E[X]=E[X_1]+E[X_2]+\dots+E[X_n]=np\end{align*}

を得る.

分散$V[X]$の導出

$X\sim\mrm{Bin}(n,p)$の分散は$V[X]=np(1-p)$である.

独立な$X_1,X_2,\dots,X_n\sim \mrm{Ber}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_n\end{align*}

と表せる.ベルヌーイ分布$\mrm{Ber}(p)$に従う確率変数の分散は$p(1-p)$だったから,分散$V$の展開公式より

\begin{align*}V[X]=V[X_1]+V[X_2]+\dots+V[X_n]=np(1-p)\end{align*}

を得る.ただし,1つ目の等号では,独立な確率変数$X$, $Y$に対して一般に

\begin{align*}V[X+Y]=V[X]+V[Y]+Cov[X,Y]=V[X]+V[Y]\end{align*}

が成り立つことを用いた.

確率母関数$G_X(s)$の導出

$X\sim\mrm{Bin}(n,p)$の確率母関数$G_X(s)$は

\begin{align*}G_X(s)=(sp+1-p)^n\end{align*}

である.

独立な$X_1,X_2,\dots,X_n\sim \mrm{Ber}(p)$を用いて

\begin{align*}X=X_1+X_2+\dots+X_n\end{align*}

と表せる.ベルヌーイ分布$\mrm{Ber}(p)$に従う確率変数の確率母関数は$sp+1-p$だったから,

\begin{align*}G_{X}(s)&=E[s^{X}]=E[s^{X_1+X_2+\dots+X_n}]

\\&=E[s^{X_1}s^{X_2}\dots s^{X_n}]

\\&=E[s^{X_1}]E[s^{X_2}]\dots E[s^{X_n}]=(sp+1-p)^n\end{align*}

を得る.ただし,最後から2つ目の等号では,独立な確率変数$X$, $Y$に対して一般に$E[XY]=E[X]E[Y]$が成り立つことを用いた.

平均・分散・確率母関数の導出(定義から直接求める方法)

ベルヌーイ分布と二項分布の関係を用いなくても二項分布の平均・分散・確率母関数を定義に基づいて求めることもできます.

平均$E[X]$の導出

$X\sim\mrm{Bin}(n,p)$の期待値は$E[X]=np$である.

$k=0$のとき$k\cdot p_X(k)=0$であることに注意すると,$X$の期待値$E[X]$の定義より

\begin{align*}E[X]&=\sum_{k=0}^{n}k\cdot p_X(k)=\sum_{k=1}^{n}k\cdot p_X(k)

\\&=\sum_{k=1}^{n}k\cdot\frac{n!}{k!(n-k)!}p^{k}(1-p)^{n-k}

\\&=np\sum_{k=1}^{n}\frac{(n-1)!}{(k-1)!(n-k)!}p^{k-1}(1-p)^{n-k}

\\&=np\sum_{k=1}^{n}\binom{n-1}{k-1}p^{k-1}(1-p)^{n-k}\end{align*}

となる.ここで,$k=\ell+1$とおき,二項定理を用いると

\begin{align*}&\sum_{k=1}^{n}\binom{n-1}{k-1}p^{k-1}(1-p)^{n-k}

\\&=\sum_{\ell=0}^{n-1}\binom{n-1}{\ell}p^{\ell}(1-p)^{(n-1)-\ell}

\\&=(p+(1-p))^{n-1}=1^{n-1}=1\end{align*}

となるから$E[X]=np$である.

途中の二項定理を使うところでは$a=p$, $b=1-p$, $m=n-1$として,二項定理の公式

\begin{align*}(a+b)^m=\binom{m}{0}a^{0}b^{m}+\binom{m}{1}p^{1}(1-p)^{m-1}+\dots+\binom{m}{m}p^{m}(1-p)^{0}\end{align*}

を使っています.

分散$V[X]$の導出

$X\sim\mrm{Bin}(n,p)$の分散は$V[X]=np(1-p)$である.

$X$の分散は

\begin{align*}V[X]&=E[X^2]-E[X]^2=E[(X^2-X)+X]-E[X]^2

\\&=E[X(X-1)]+E[X]-E[X]^2\end{align*}

で求まる.$E[X]=np$は上で求めたから,あとは$E[X(X-1)]$を求めればよい.

$k=0,1$のとき$k(k-1)\cdot p_X(k)=0$であることに注意すると,$X(X-1)$の期待値$E[X(X-1)]$は定義より

\begin{align*}E[X(X-1)]&=\sum_{k=0}^{n}k(k-1)\cdot p_X(k)=\sum_{k=2}^{n}k(k-1)\cdot p_X(k)

\\&=\sum_{k=2}^{n}k(k-1)\cdot\frac{n!}{k!(n-k)!}p^{k}(1-p)^{n-k}

\\&=n(n-1)p^2\sum_{k=2}^{n}\frac{(n-2)!}{(k-2)!(n-k)!}p^{k-2}(1-p)^{n-k}

\\&=n(n-1)p^2\sum_{k=2}^{n}\binom{n-2}{k-2}p^{k-2}(1-p)^{n-k}\end{align*}

となる.ここで,$k=\ell+2$とおき,二項定理を用いると

\begin{align*}&\sum_{k=2}^{n}\binom{n-2}{k-2}p^{k-2}(1-p)^{n-k}

\\&=\sum_{\ell=0}^{n-2}\binom{n-2}{\ell}p^{\ell}(1-p)^{(n-2)-\ell}

\\&=(p+(1-p))^{n-2}=1^{n-2}=1\end{align*}

となるから$E[X(X-1)]=n(n-1)p^2$である.よって,

\begin{align*}V[X]=n(n-1)p^2+np-(np)^2=n(p-p^2)=p(1-p)\end{align*}

である.

途中の二項定理を使うところでは$a=p$, $b=1-p$, $m=n-2$として,二項定理の公式

$(a+b)^m=\binom{m}{0}a^{0}b^{m}+\binom{m}{1}p^{1}(1-p)^{m-1}+\dots+\binom{m}{m}p^{m}(1-p)^{0}$

を使っています.

確率母関数$G_X(s)$の導出

$X\sim\mrm{Bin}(n,p)$の確率母関数$G_X(s)$は

\begin{align*}G_X(s)=(sp+1-p)^n\end{align*}

である.

確率母関数$G_X(s)$の定義より

\begin{align*}G_X(s)&=E[s^X]=\sum_{k=0}^{n}s^k\cdot p_X(k)

\\&=\sum_{k=0}^{n}s^k\cdot\frac{n!}{k!(n-k)!}p^{k}(1-p)^{n-k}

\\&=\sum_{k=0}^{n}\frac{n!}{k!(n-k)!}(sp)^{k}(1-p)^{n-k}

\\&=(sp+1-p)^n\end{align*}

である.ただし,最後の等号では二項定理を用いた.

参考文献

以下は参考文献です.

統計学

[久保川達也 著/東京大学出版会]

現代の統計学は社会学・心理学・機械学習など様々な分野に応用されている極めて実学的な分野です.

本書は統計学の基礎を基礎から丁寧に解説した初学者向けのテキストで,大きく

- 第1部:統計データの整理と記述のための基礎事項

- 第2部:統計学で必要となる確率の知識

- 第3部:統計的推測の基礎事項

- 第4部:社会・経済・時系列データ

の4部構成になっています(本書「はしがき」より).

著者が大学2年生に向けて行った講義に基づいて書かれており,数理的な計算はしっかり追いつつも分かりやすさを重視した記述になっています.

難易度としては統計検定の2級を少し超えたくらいになっており,部分的には準1級レベルの箇所もあります.

章末問題も豊富にあり,統計検定の2級対策としても利用できます.

さらに,著者による章末問題の略解がウェブにアップロードされているのも独学者にはありがたい点です.

コメント